Gemini kann es, ChatGPT kann es, Claude kann es. Die Zeiten, in denen große Sprachmodelle jeweils nur für Text- oder Bildgenerierung verwendet wurden, sind längst vorbei. Bislang waren die Ergebnisse allerdings nicht immer überzeugend. Gerade mit der Einbindung von Text in Bilder hatten auch große KI-Chatbots ihre Probleme.

Ein Update von ChatGPT will jetzt Abhilfe schaffen. Firmenangaben zufolge soll der native Bildgenerator des GPT-4o-Modells unter anderem bis zu 20 Objekte, die miteinander in Bezug stehen, korrekt darstellen können.

Die Beispielbilder aus dem Blogpost des KI-Unternehmens sind stellenweise beeindruckend. Die Realität von Nutzer:innen, die die neue Funktion nur mal ausprobieren wollen und Prompts nicht verfeinern, sieht allerdings anders aus.

Empfehlungen der Redaktion

Deswegen haben wir den ChatGPT-Bildgenerator einem intensiveren Test unterzogen und uns an einigen möglichen Nutzungsszenarien entlanggehangelt. Weil auch OpenAI diese Fähigkeit besonders herausstellt, fokussieren wir uns auf die Erstellung von Grafiken mit viel Text. Dazu gehören Infografiken und fotorealistische Bilder, die Text in natürlicher Umgebung, also auf Buchseiten oder auf Whiteboards, abbilden.

Außerdem testen wir, wie weit das Modell bei der Abbildung von Personen des öffentlichen Lebens geht. OpenAI gibt in der dazugehörigen System-Card an, diesbezüglich weniger Einschränkungen vorzunehmen. Missbräuchliche Nutzung will das KI-Startup aber trotzdem unterbinden. Wie leicht lassen sich die Sicherheitsschranken umgehen?

Textdarstellung klappt fast nie im ersten Anlauf

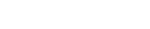

OpenAIs Mission, auch Text sinnvoll in KI-generierte Bilder zu integrieren, ist nur teilweise ein Erfolg. Anhand eines relativ ausführlichen Prompts lassen wir uns von ChatGPT eine Szene in einem Vorlesungssaal generieren.

Ein Uniprofessor, der mit dem Rücken zum in der zweiten Reihe sitzenden Betrachter steht, zeigt darin mit einem Laserpointer auf ein Smartboard. Darauf sollen zwei Spalten Text mit Überschrift, Stichpunkten und einem beispielhaften Diagramm abgebildet werden. Zusätzlich soll GPT-4o drei Bücher auf einem Schreibtisch generieren, zwei mit ausgedachten deutschen Titeln, eines mit dem japanischen, in Kanji geschriebenen Originaltitel.

Alles, was nichts mit Textgenerierung zu tun hat, erledigt ChatGPT ordentlich. 100-prozentig fotorealistisch ist das Ergebnis zwar nicht, wirkt aber auf den ersten Blick glaubhaft. Nur den Blickwinkel bekommt der KI-Chatbot nicht so hin, wie wir es uns vorgestellt haben.

Korrekturwünsche verschlimmbessern das Ergebnis

Anders sieht es bei dem Text auf dem Smartboard und den Bücherrücken aus. Ersterer weist nur eine Handvoll kleine Fehler auf, zweiterer ist komplett verhunzt und fragmentiert.

Nachdem wir ChatGPT auffordern, den Professor durch eine Professorin zu ersetzen und zwei weitere Bücher einzufügen, verschwinden die Fehler auf dem Smartboard, auf den Bücherrücken schleichen sich dafür neue ein. Das vierte Buch erstellt ChatGPT nicht mal mehr, die Titel sind bis auf A World History of Art unleserlich.

Mit der Darstellung von Text in Bildern hat ChatGPT immer noch Probleme, gerade bei aufeinander aufbauenden Prompts (Bild: ChatGPT / t3n)

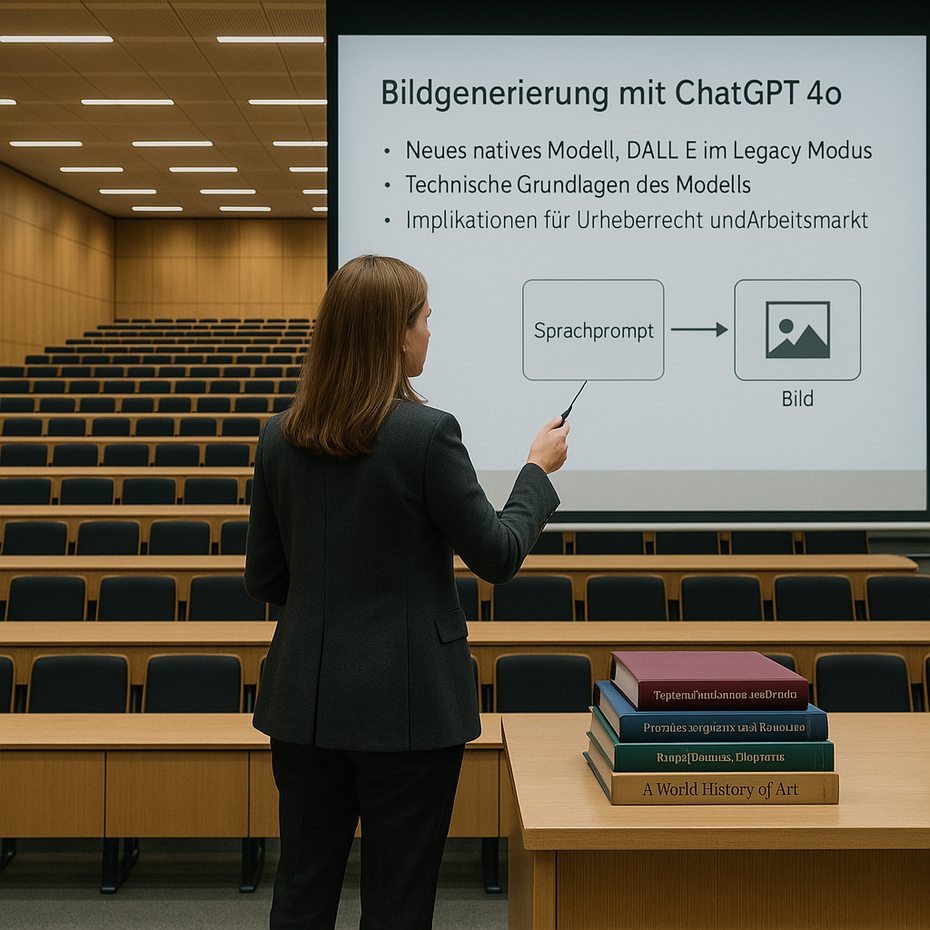

Um das Modell etwas zu entlasten, lassen wir es zusätzlich ein Kino mit der dazugehörigen Anzeigetafel und eine Person generieren, die in einem Wald ein Buch liest. Aber auch hier geht die wortwörtliche Text-Bild-Schere wieder auf.

Bei viel Text auf wenig Raum scheitert GPT-4o. (Bild: ChatGPT / t3n)

Das rein Visuelle setzt ChatGPT ansprechend um. Der Lorem-Ipsum-Text auf den Buchseiten ist dafür reinstes Kauderwelsch, und auch beim Kino-Beispiel gibt es Mängel in den Details. Der Text, den wir auf einem Poster für eine Sneak-Preview abgebildet haben wollen, ist fragmentiert, statt das Plakat ins Fenster des Kassenhäuschens zu hängen, ersetzt es selbiges.

Im Kino-Beispiel stellt GPT-4o große Textblöcke halbwegs sauber dar, in den Details wird es wieder unleserlich. (Bild: ChatGPT / t3n)

Infografiken als Stresstest für GPT-4o

Nachdem ChatGPT diese relativ simple Aufgabe nur in Teilen bewältigt, schrauben wir den Schwierigkeitsgrad im zweiten Schritt etwas nach oben. GPT-4o soll für uns aus strukturierten und unstrukturierten Daten verständliche Infografiken generieren.

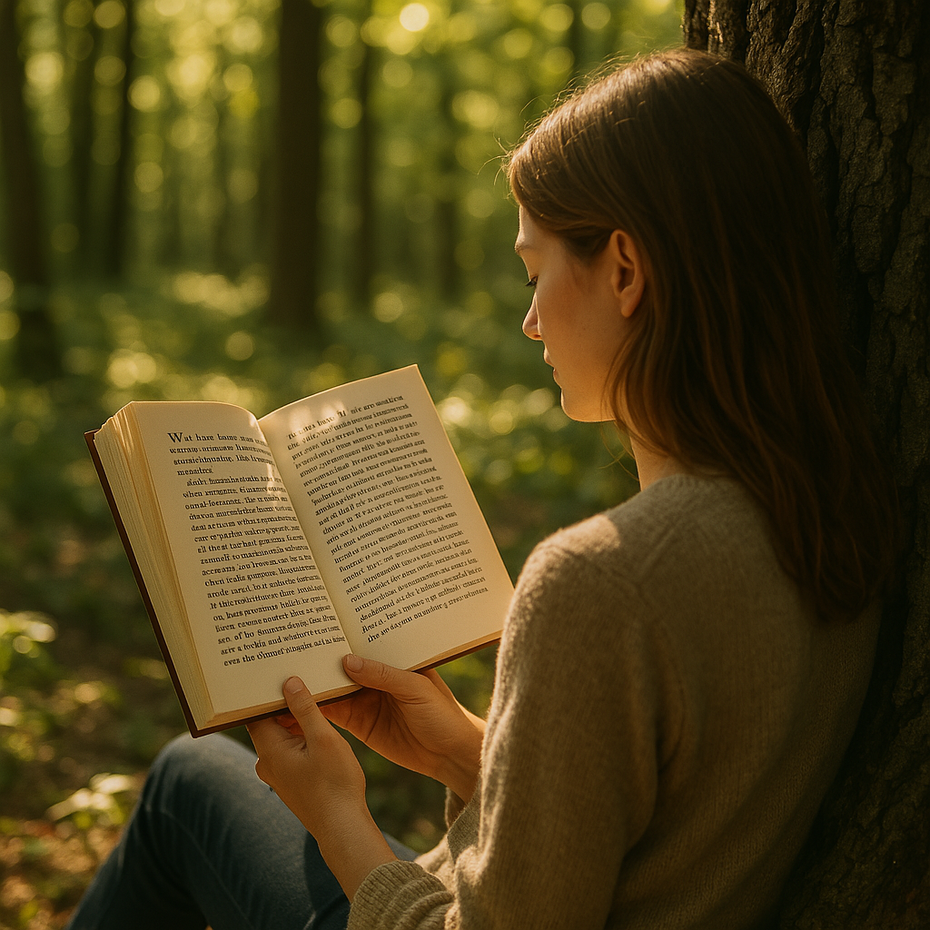

Als erstes nutzen wir die Upload-Funktion des Tools und laden eine CSV-Datei aus dem Dashboard Deutschland des Statistischen Bundesamts hoch. Darin finden sich maschinenlesbar aufbereitet die prozentuale Veränderung verschiedener Preisindizes zum jeweiligen Vormonat.

Hier glänzt GPT-4o. Zusätzliche Anforderungen – etwa nur die Verbraucherpreise abzubilden, einen engeren Zeitrahmen auszuwählen und die Periode des Ukrainekrieges zu markieren – setzt der KI-Chatbot fehlerfrei um. Bei der gestalterischen Darstellung ist allerdings noch Luft nach oben.

Als wir eine Überschrift und einen Untertitel einfügen wollen, vertauscht ChatGPT zuerst die Textblöcke. Auch optisch sieht die Grafik nicht besser oder sogar schlechter aus als das, was jedes andere Tabellenverarbeitungsprogramm oder spezielle Tools wie Datawrapper oder Flourish können. Mit etwas Nachjustieren kommt man allerdings zu einem passablen Ergebnis. Ein weiterer Vorteil ist, dass man sich ein paar Arbeitsschritte und die Einarbeitung in neue Tools spart.

So sieht eine Infografik mit strukturierten … (Bild: ChatGPT / t3n)

… und so mit unstrukturierten Daten aus. (Bild: ChatGPT / t3n)

Bei unstrukturierten Daten kann GPT-4o menschliche Logik nicht ersetzen

Geht es an unstrukturierte Daten, tritt wie bei vielen Chatbots der Dunning-Kruger-Effekt zutage. GPT-4o soll rein auf den tatsächlich vorhandenen Zahlen aus einem Infotext zu einer professionell erstellten Infografik eine eigene Grafik erstellen.

Wir geben explizit an, dass das Tool keine Zahlen schätzen oder erfinden soll, und trotzdem fabuliert GPT-4o Prozentzahlen, die sich so im Text nicht wiederfinden.

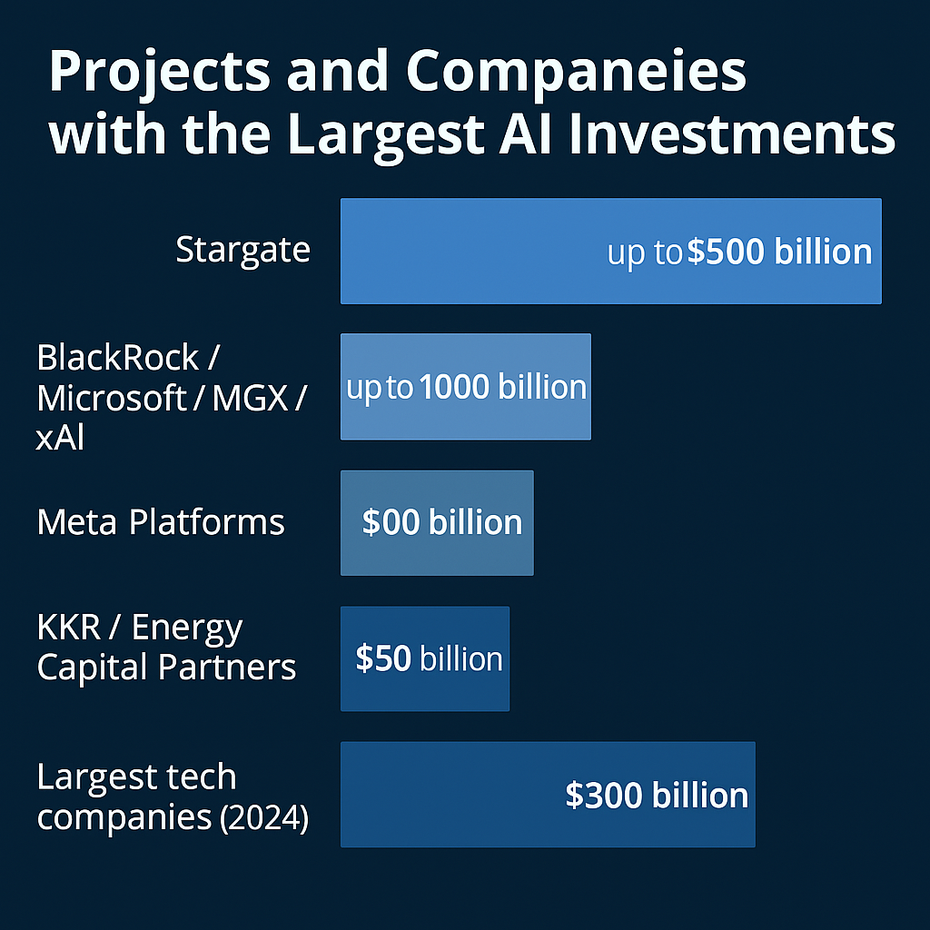

In einem zweiten Text, in dem eine Reihe von Investitionen in KI-Infrastruktur mit Höhe und den dahinterstehenden Firmen angegeben wird, schlägt sich ChatGPT kaum besser. Die Balkenlängen stehen in komplett falscher Relation zu den angegebenen Geldbeträgen.

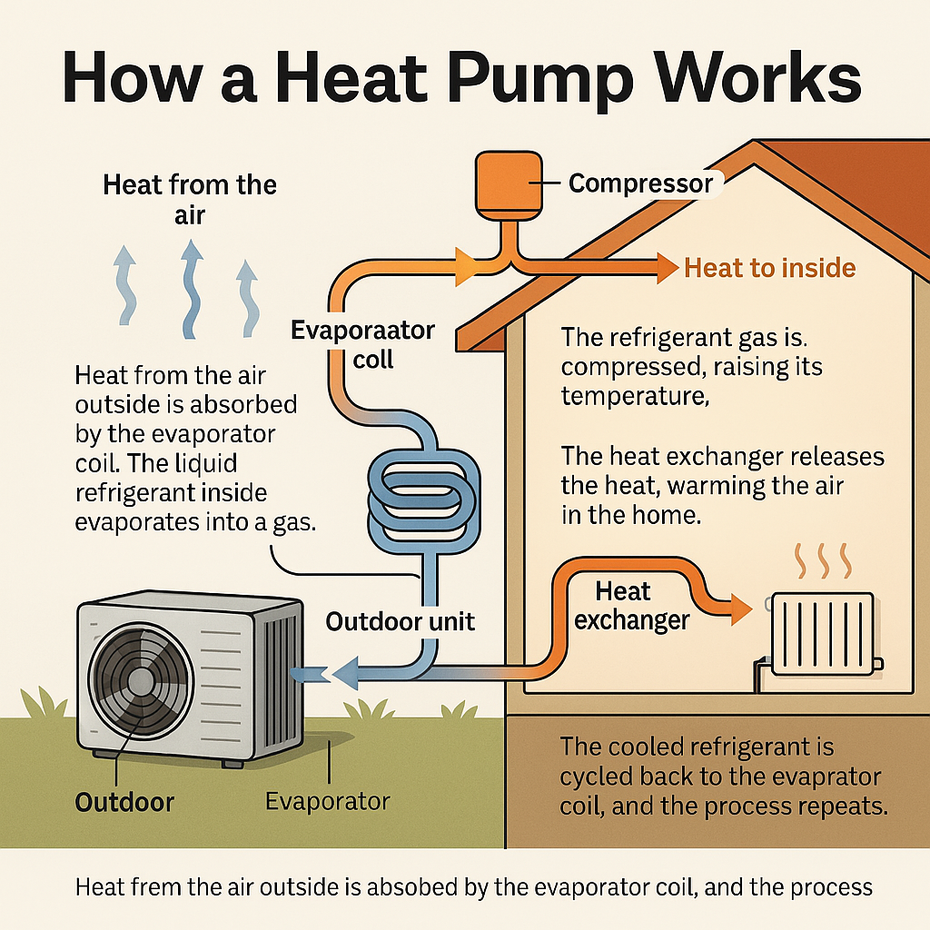

Lässt man ChatGPT vollkommen freie Hand, kommen ebenfalls durchwachsene Ergebnisse dabei heraus. Auf die Anfrage hin, eine Infografik zur Funktionsweise einer Wärmepumpe zu erstellen, ist das Ergebnis zwar anschaulich, die dargestellte Funktionsweise inklusive der Beschriftung der einzelnen Elemente aber im Detail falsch. Die Grafik ist ohne händische Nachbesserung nicht benutzbar, zumal jegliche Quellenangabe fehlt.

So funktioniert eine Wärmepumpe laut ChatGPT … (Bild: ChatGPT / t3n)

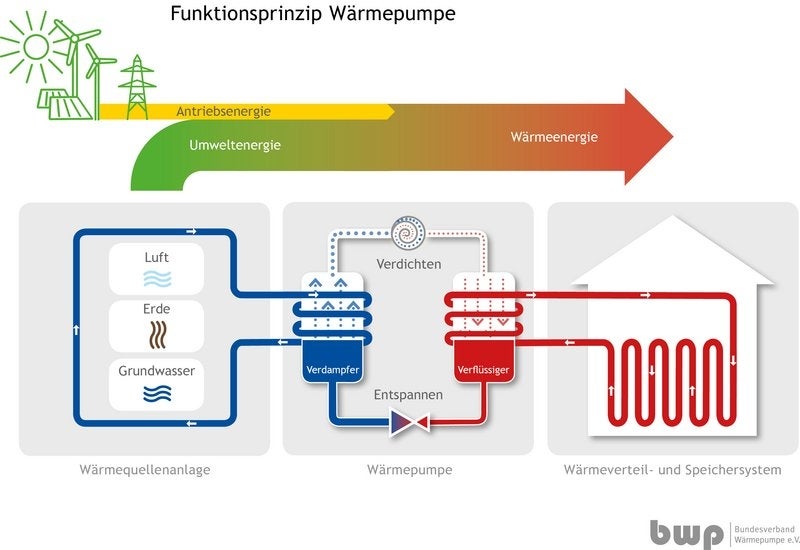

… und so in der Realität. (Bild: Bundesverband Wärmepumpe e. V.)

Das Problem mit den Deepfakes

Eine falsch dargestellte Infografik oder unleserlicher Text sind vielleicht ärgerlich, aber in den meisten Fällen unkritisch. Wenn es um die Generierung von Deepfakes von bekannten Persönlichkeiten geht, wird aus Spaß schnell Ernst.

OpenAI verspricht sich laut eigenen Angaben in der System-Card zur GPT-4o-Bildgenerierung von der Lockerung „nützliche und vorteilhafte Einsätze in Bereichen wie Bildung, Geschichte, Satire und politische Rede“. Außerdem könnten Personen Generierungsversuchen durch Opt-out widersprechen.

In unserem Testlauf haben wir versucht, Bilder von prominenten Figuren der Unterhaltungsbranche und der Politik wie Scarlett Johansson, Tom Hiddleston oder Angela Merkel zu generieren. Die Ergebnisse teilen wir aus offensichtlichen Gründen nicht. Deutlich wird allerdings, dass es bei einigen Persönlichkeiten des öffentlichen Lebens mehr Einschränkungen als bei anderen zu geben scheint.

Von Paparazzi-Bashing bis AMA-Selfie

Johansson, die OpenAI schon im vergangenen Jahr mit ihren Anwälten gedroht hatte, scheint für GPT-4o etwa ein rotes Tuch zu sein. Egal, wie wir den dazugehörigen Prompt modifizieren, ChatGPT will keine Bilder der Schauspielerin generieren.

Anders sieht es bei weniger prominenten Beispielen aus. Einer Schauspielerin konnten wir problemlos ein Abendkleid auf dem roten Teppich anziehen und ein Schild mit der Aufschrift „This paparazzo sux“ in die Hand geben. Eine andere Figur des öffentlichen Lebens versetzten wir in eine fiktive Ask-me-Anything-Situation auf Reddit und ließen sie ebenfalls ein mit „Hey Reddit, AMA“ beschriftetes Schild hochhalten.

Einer dritten Person schließlich zogen wir ein „I love X“-Shirt an und gaben ihr eine Tüte einer bekannten Fast-Food-Kette in die Hand. Je nach weiterer Optimierung könnte daraus schnell Schleichwerbung werden. Die Details in den generierten Bildern stimmten nicht immer hundertprozentig mit den Vorbildern überein. Teilweise musste man die Unterschiede zwischen Fake und Original aber mit der Lupe suchen.

Auf Anfrage von t3n verweist OpenAI auf die System-Card, die die offiziellen Einschränkungen genauer auflistet, gerade was pornografisches oder politisches Material angeht. Außerdem betont das KI-Startup, dass die Nutzungsbedingungen missbräuchliche Nutzung von ChatGPT verbieten. Das schreckt aber natürlich Kriminelle nicht ab.

GPT-4o ist kein Allzweck-Grafiktool, sondern Ausgangspunkt für eigene Leistung

Unsere Tests zeigen, dass OpenAI die großen Versprechungen, gerade Text im Bild jetzt besser und fehlerfreier darstellen kann, nicht halten kann. Manchmal werden die Texte korrekt generiert, manchmal entsteht Kauderwelsch, und je länger der Kontext wird, desto konfuser das Ergebnis.

Infografiken kann GPT-4o erst recht nicht darstellen, ob mit viel oder wenig Kontext im Prompt. Die Ausnahme: Wenn man GPT-4o mit gut aufbereiteten Daten füttert, ist das Ergebnis nach ein paar wenigen Zusatzprompts vorzeigbar. Dafür braucht es allerdings keine ressourcenintensive generative KI. Dieselbe Aufgabe erledigen andere Tools zur Datenvisualisierung oft genauso schnell und präzise.

Was die reine Bildgenerierung angeht, liefert GPT-4o saubere Ergebnisse, auch mit Prompts mit wenig Kontext. Das kann man allerdings auch kritisch sehen.

Denn das KI-Tool scheint zum Beispiel je nach Promi mal mehr, mal weniger strikt mit den eingezogenen Sicherheitsvorkehrungen umzugehen. Dadurch wird die Deepfake-Gefahr noch größer. Auch andere kriminelle Einsatzzwecke wie Versicherungsbetrug durch das Einfügen von Schäden in echte Fotos sind jetzt eher denkbar.

Für Hobbyprojekte und erste Skizzen eignet sich die native Bildgenerierung von GPT-4o. Für öffentlich ausgerichtete Einsatzzwecke birgt sie zu viele Risiken. Entweder, weil die Empfänger:innen nicht erkennen, ob das Bild echt oder fake ist, oder weil das Ergebnis, gerade im Zusammenspiel mit Text, zu viel Fehlerpotenzial aufweist und Nachprompten zeit- und ressourcenintensiv ist.